Meta AI 为什么会开源 Llama2 呢?

咱们先不看原因,看疗效。Meta

自从Meta

开源

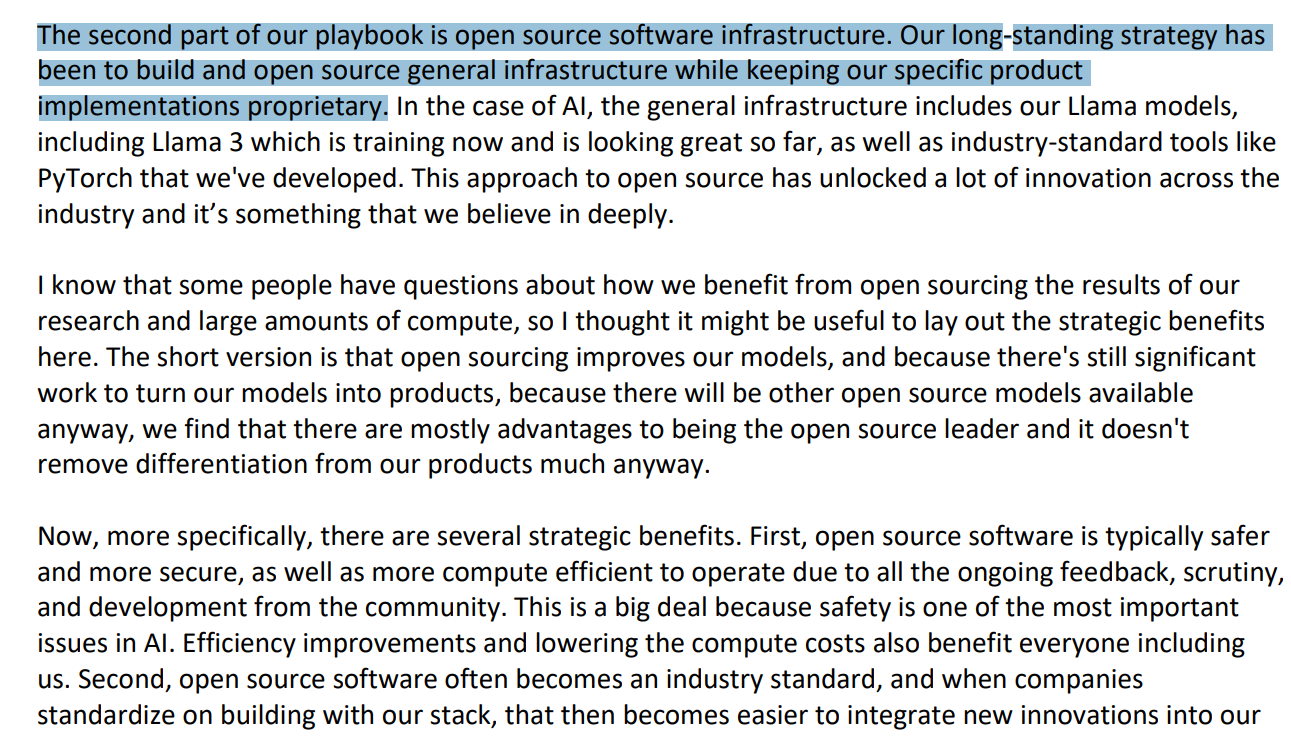

在2023 年第四季度财报电话会议中,扎克伯格

扎克伯格称“开源通用基础设施”有以下三点战略好处:

- 开源软件

- 通过开源成为行业标准,使得将市面上的创新、解决方案、场景等各方面资源融入Meta自家的产品时变得更加容易;

- 开源在开发者和研究人员中极受欢迎,有助于为Meta吸引人才。

第一重目的,打不过就掀桌子

真正的狠人,从来就不是“打不过就加入”,而是“打不过就掀桌子”。你OpenAI

Meta的开源策略,一方面博得了足够的市场好感度;另一方面改变了AI大模型

第二重目的,迅速占领市场

回看PC操作系统,即使Windows这么强势,开放的Linux生态也早就超过了半壁江山,开源的生命力是经过了无数次验证的。

通过开源,Meta不仅能够在市场推广中获得极大助力,还能吸引更多的开发者、初创企业加入到他们的技术路线中来,撒豆成兵

而Meta,自然成为这个帝国当之无愧的王。

现实数据也很好地印证了这一点。据Meta透露,在Llama2

第三重目的,剑指生态

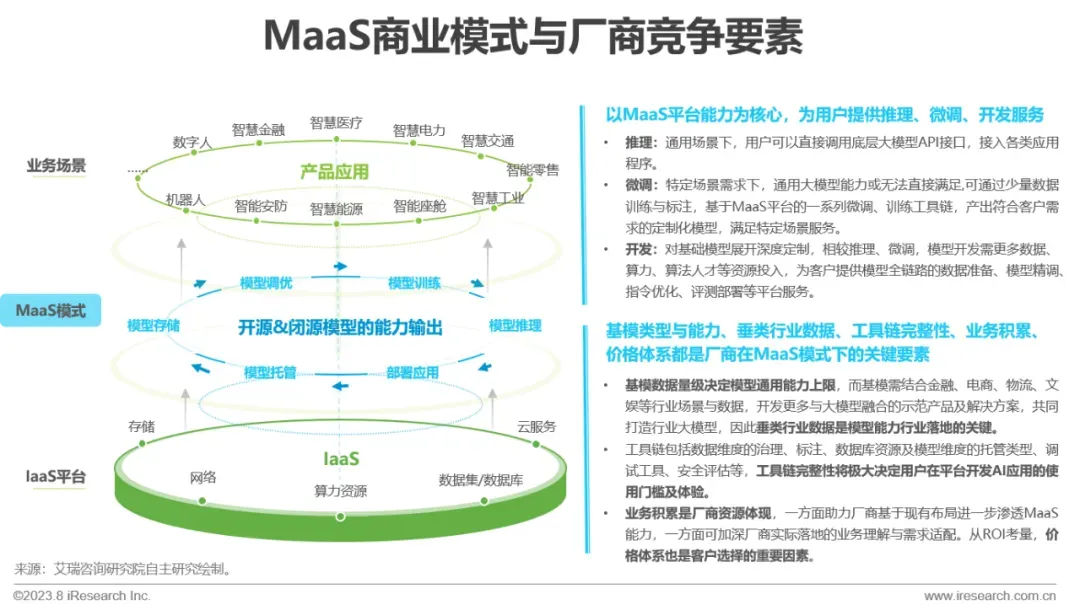

大模型生态系统包括数据要素、算力服务、基础理论、通用大模型、垂类大模型

OpenAI紧锣密鼓地拿出Assistant API

然而这个生态的建设,是需要投入大量的资源和技术力量的。以开源社区

苹果停了10年的造车杀入AI赛道;一夜之间Anthropic公司

在这场波澜壮阔的变革中,普通技术人员以及个人创业者的路该怎么走呢?李彦宏

建议每一个技术人员,都去听一下知乎知学堂和AGI课堂联合推出的免费公开课——知乎知学堂联合AGI课堂推出的程序员的AI大模型进阶之旅。

这个课正是为了适应当下AI大模型的发展而推出的,由几位业内大佬主讲,会带你深度了解大模型的前世今生,学习整套的数据处理、训练、fine-tune模型

重要的是有 AI 大模型学习资源包,以及好用的 AI工具等。感兴趣的可以关注一下 ↓ ↓ ↓

更难得的是它不仅让你了解大模型背后的原理和实操技术,还能从商业的角度带你深度解析此轮AI变革和以往有何根本不同。相信听完公开课之后,你会拥有醍醐灌顶的认知和豁然开朗的思路。

模型都开源了,怎样赚钱呢?

想想开源的安卓怎样为谷歌赚钱的吧。广告收入(AdSense和AdWords

再说了,轮子虽然开源了,可人家还卖车呢。“我们的策略是构建并开放源代码通用基础设施,同时保留我们的具体产品实现为专有技术。”Meta官方说。

要知道OpenAI之所以名为OpenAI,是因为最早GPT-1、GPT-2都是开源的,GPT-3开源之后又闭源了。因为这个原因,甚至有人戏称OpenAI应当改名为“CloseAI

那么,开源会不会削弱Meta的核心竞争力?会不会有“青出于蓝胜于绿”的大模型公司起来,踩着Meta的脑袋“上春山”呢?Meta早想到了。开源的环节、流程和各种限制条件设置得特别细,以至于被很多专业人士嘲讽“违返开源精神”。

最后,想想Meta的市值。光一个开源的好名声,就已经让Meta赢麻了。

更多回答

meta这是卷死openai的阳谋,让openai无利可图

chatGPT的api收费和订阅虽然很贵,但是现阶段他们还是亏钱运营的,唯一指望是利用现阶段抢占市场以及期望未来成本可以降低(技术升级加大用户量摊平成本)来实现盈利

meta开源这招就是针对这个,反正我没厉害的产品跟你竞争,而且llama1开源的效果还不错,已经有一些可以凑合一下替代chatGPT了,那我直接授权llama2可以商用,让openai 陷入免费模型的汪洋大海,让你越升级越亏本,越运营越亏本,卷死你

这也是微软为什么跟meta合作的原因,你这让大模型免费扩散是阳谋,只孤注一掷openai风险太大,卷不赢不如加入,还可以卖云服务赚钱,说不定到时openai爆发了,还可以两头赚钱,即使最后openai被卷死了,也就赔了10B,但至少云服务这大生意还能赚钱,说不定赚到更多

至于产品,慢慢做呗,反正meta最近几年产品都拉胯,把主要竞争对手拖累下,而且meta还没放弃metaverse(虽然也是烂的一坨的产品)

1、Meta做了一个艰难的决定。ChatGPT捷足先登,想扳回很难了,再说LLaMA2是个模型,对标的是gpt3.5或gpt4那样的模型,并不是像ChatGPT那样的一个产品,从模型到产品之间还有很多步,追赶太困难了

2、与其那样追赶,还不如做大语言模型界的Android,其实这个目的也达到了,短短几个月,有多少带“驼”的微调大模型百模齐放啊,但基础模型核心的东西还是Meta在掌握

3、商业上的考虑,与其合作的居然有ChatGPT的金主Microsoft,这说明两家都想促进云算力的推广,毕竟不是所有人都能买得起4块A100开始微调的,GPU用微软云也是很多人的一个选项

4、生态上的考虑,从原始模型公开算法和语料,和支持微调,到支持lora这样的低算力设备的微调和词表扩充,作者也实践了一个微调例子,过程相对来说还是比较顺利的。小五哥:在16G的推理卡上微调Llama-2-7b-chat

5、以后的趋势是,大语言模型像操作系统,PC端和手机端人手一个,自问自答,不联网,零门槛,像 https://gitclone.com/aiit/chat/ ,都是开源资源,有一定的算力,就能自己搭,所以就大模型本身(chatgpt不只是模型,是产品)也没什么商业模式。